CHATGPT中GPT的缩写解读:探索GPT作为生成预训练Transformer的缩写含义

GPT,作为生成预训练Transformer的缩写,已经引起了广泛的关注,特别是在自然语言处理领域。本文将从多个角度对GPT进行解读,并分享些实时信息,以满足读者的需求。

GPT的基本含义

GPT是“生成预训练Transformer”的缩写。在自然语言处理领域,Transformer是种重要的神经网络架构,而GPT则是基于这种架构的种预训练模型。预训练模型是指在大规模语料库上进行预训练,使得模型能够学习到语言的般性知识,然后再在特定的任务上进行微调,以达到最优的性能。

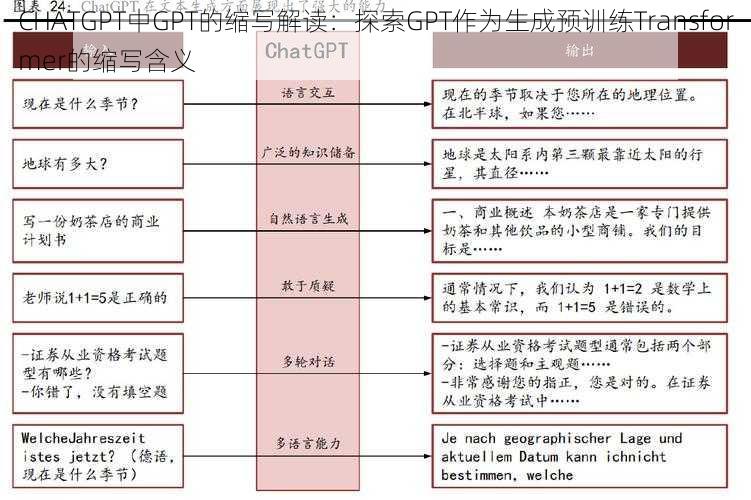

GPT的应用价值

GPT的应用价值主要体现在自然语言生成任务上。由于其强大的语言生成能力,GPT已经被广泛应用于文本生成机器翻译问答系统等多个领域。GPT还可以用于文本分类情感分析语义理解等任务,为自然语言处理领域的发展提供了强大的支持。

GPT的最新发展

随着技术的不断进步,GPT系列模型也在不断升级。最新的GPT模型在性能上有了显著的提升,不仅能够生成更加流畅自然的文本,还能够更好地处理复杂的语言现象。GPT模型还在多模态预训练跨语言预训练等方面进行了尝试,为未来的自然语言处理研究提供了新的方向。

实用建议和有趣故事

对于想要深入了解GPT的读者,我们建议首先学习Transformer的基本原理,然后了解GPT的预训练过程和微调方法。还可以参考些开源的GPT应用项目,了解如何在实践中应用GPT。

关于GPT的有趣故事,我们可以分享个例子。有人使用GPT模型创作了篇短篇小说,竟然使得许多读者误以为是人类作者所写,这充分展示了GPT模型的强大语言生成能力。

深入分析

从技术层面来看,GPT的成功得益于其强大的神经网络架构和大规模的预训练语料库。GPT还采用了多种技术来提升性能,如自回归生成多任务学习等。GPT也存在些挑战,如计算资源消耗大训练时间长等。未来的研究将需要解决这些,以进步推动GPT的发展。

GPT作为生成预训练Transformer的缩写,已经在自然语言处理领域取得了显著的成果。本文旨在为读者提供关于GPT的基本含义应用价值最新发展实用建议和深入分析等方面的实时信息,以满足读者的需求。